File robots.txt là gì và làm thế nào để tối ưu chúng cho SEO

17 Th11, 2021 admin

Có bao giờ bạn đọc được vài tip hoặc trick trên internet nói về file robots.txt để tối ưu SEO hiệu quả chưa?

File robots.txt có tác dụng dẫn đường và chỉ lối cho bộ máy tìm kiếm.

Rằng nó sẽ được và không được thu thập thông tin gì trên website của bạn.

Điều đó đã khiến nó thực sự rất quan trọng cho SEO.

Trong bài viết này tôi sẽ hướng dẫn bạn làm thế nào để tạo một file robots.txt để tối ưu SEO hiệu quả.

File robots.txt là gì

Robots.txt là một file dạng text mà khi xây dựng website bạn có thể tạo ra để nói cho những con bọ của bộ máy tìm kiếm rằng.

Làm thế nào để thu thập thông tin và index các trang trên website đó.

Đọc thêm bài Crawl và Index là gì? Cách mà Google đang thu thập thông tin website của bạn

Bạn có thể tìm thấy file robots.txt ở thư mực gốc của website hay còn gọi là folder chính của website đó.

Về cơ bản một file robots.txt sẽ có dạng như này:

User-agent: [user-agent name] Disallow: [URL string not to be crawled] User-agent: [user-agent name] Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap]

Bạn có thêm nhiều dòng khác trong cấu trúc trên để allow hoặc disallow một đường dẫn cụ thể nào đó và thêm nhiều sitemap khác.

Nếu bạn không muốn disallow một URL nào cả, thì các con bọ của công cụ tìm kiếm sẽ được phép thu thập tất cả mọi thứ trên website đó.

Đây là một ví dụ về file robots.txt cơ bản hay sử dụng trong WordPress:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Sitemap: https://example.com/sitemap_index.xml

Trong ví dụ trên, tôi đã cho phép công cụ tìm kiếm thu thập thông tin và index file có trong thư mục uploads.

Sau đó thì tôi lại không cho phép nó thu thập 2 folder plugins và wp-admin và cuối cùng là thêm sitemap

Bạn có cần đến file robots.txt cho website WordPress không?

Mặc định thì kể cả bạn không có file này thì công cụ tìm kiếm nó vẫn index website.

Tuy nhiên đôi khi có một số file quan trọng bạn không muốn nó bị lộ thông tin ra ngoài thì đây là lúc cần nó.

Nếu bạn là một người mới bắt đầu và mới xây dựng blog với số lượng nội dung ít ỏi thì đây chắc chắn không phải vấn đề bạn cần để ý.

Nhưng dần dần khi website bạn phát triển có nhiều nội dung hơn, nhiều organic traffic hơn.

Thì bạn sẽ cần phải để ý về vấn đề số lượng thông tin bị thu thập.

Và đây là lý do tại sao file robots.txt lại quan trọng đến vậy

Các con bọ của công cụ tìm kiếm có một giới hạn nhất định cho mỗi website.

Có nghĩa là mỗi lần đi chúng sẽ thu thập một số lượng page nhất định trên website đó.

Nếu nó vẫn chưa thu thập xong hết tất cả các page thì lần sau nó sẽ quay lại và tiếp tục.

Vì vậy mà website với lượng bài viết lớn thì sẽ có thể việc index sẽ bị ảnh hưởng và chậm hơn.

Để khác phục điều này thì bạn có thể disallow một số page không cần thiết trong WordPress như admin, folder plugins và themes.

Như vậy là bạn đã bớt được số lượng thông tin mà các con bọ không cần thiết phải thu thập, và nó sẽ khiến những nội dung quan trọng được index nhanh hơn.

Còn trong một số trường hợp đặc biệt bạn còn có thể ngăn công cụ tìm kiếm không index một số Page hoặc Post nào đó trên website của bạn.

Mặc dù nó không phải là cách tốt nhất để che dấu nội dung đó, nhưng nó cũng khá hiệu quả để không bị tìm thấy trên kết quả tìm kiếm.

Một số ví dụ về file robots.txt mà bạn có thể sử dụng

Một số blog có file robots.txt khá đơn giản, mỗi website có một nội dung khác nhau tùy vào nhu cầu cụ thể của họ

User-agent: * Disallow: Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

File robots.txt trên cho phép tất cả các con bot thu thập tất cả các thông tin trên website đó và có chứa thêm Sitemap XML.

Nhân tiện nếu bạn chưa biết tạo sitemap hãy xem hướng dẫn cách tạo XML Sitemap

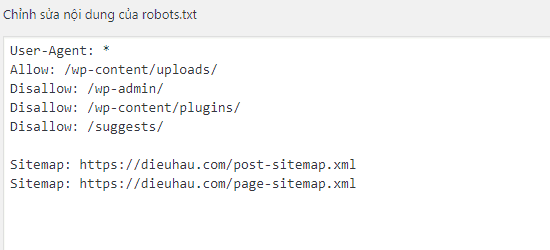

Nếu bạn đang sử dụng WordPress Diều Hâu gợi ý bạn sử dụng file robots.txt có dạng như sau:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Disallow: /readme.html Disallow: /refer/ Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

Với dạng này cho phép công cụ tìm kiếm thu thập tất cả các file có trong thư mục uploads như ảnh.

Và disallow file plugins, khu vực admin, file readme, và affiliate link.

Nhớ thêm sitemap vào robots.txt để Google có thể dễ dàng thu thập mọi page đang có trên website nhé.

Giờ thì bạn đã hiểu cơ bản file robots.txt là gì và nó có cấu trúc như thế nào.

Làm thế nào để tạo file robots.txt trong WordPress

Có 2 cách để tạo file robots.txt trong WordPress, nói chung là đều khá đơn giản. Trong bài viết này tôi sẽ hướng dẫn bạn cả 2 cách.

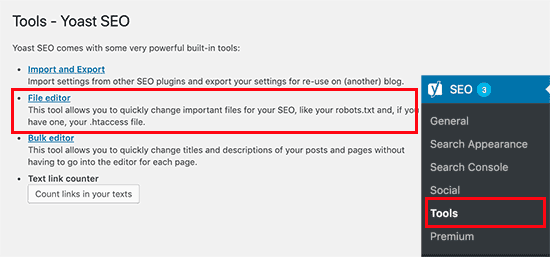

Cách 1: Tạo file robots.txt bằng Yoast SEO plugin

Nếu bạn đang sử dụng Yoast SEO thì nó có sẵn tính năng tạo file robots.txt cho bạn.

Bạn có thể tạo và chỉnh sửa trực tiếp từ khu vực admin.

Đơn giản đi đến menu SEO » Tools và chọn File Editor

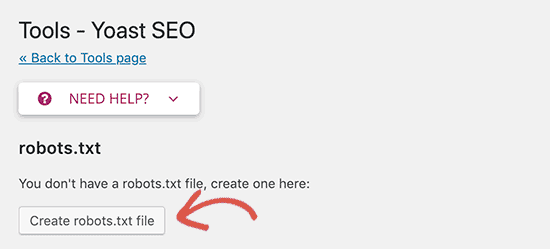

Ngay sau đó Yoast SEO sẽ hiển thị file robots.txt bạn đã có.

Nếu không có file robots.txt. Yoast SEO sẽ tạo giúp bạn bằng bấm vào nút dưới đây.

Mặc định thì file robots.txt được Yoast SEO tạo có cấu trúc như sau.

Tham khảo Yoast SEO Premium với nhiều tính năng cao cấp hơn thực sự nó rất hữu ích.

User-agent: * Disallow: /

Lưu ý: Với cấu trúc như này thì tất cả các công cụ tìm kiếm sẽ bị chặn và không thể thu thập nội dung trên website bạn được.

Tốt nhất là nên sử dụng cấu trúc Diều Hâu khuyên dùng ở trên nhé các bạn, hoặc tự tạo cho riêng mình. Và nhớ lưu lại nhé.

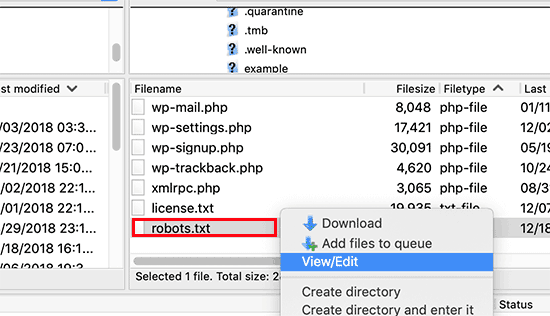

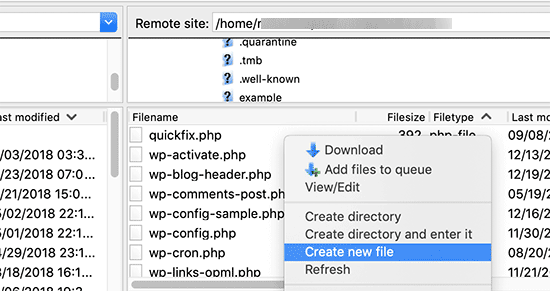

Cách 2: Tạo file robots.txt bằng cách thủ công sử dụng FTP

Với phương pháp này bạn cần sử dụng FTP client để chỉnh sửa file trên VPS hoặc nếu bạn dùng Hosting có Cpanel có thể vào File Manager để chỉnh sửa.

Truy cập vào thư mục chính trên WordPress bằng FTP và edit trực tiếp như dưới đây.

Nếu bạn không thấy file robots.txt nào, hãy tạo bằng cách chuột phải và creat new file.

File robots.txt đơn giản chỉ là một file text bạn có thể download nó về edit bằng notepad, notepad++ hoặc phần mềm tương tự, save lại và upload lên lại hosting là được.

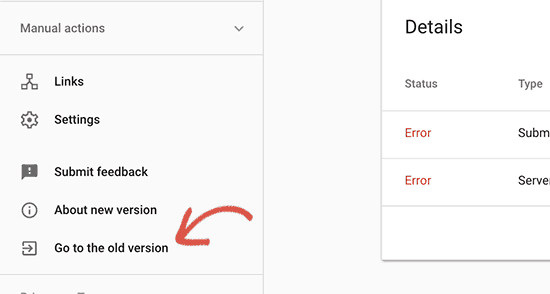

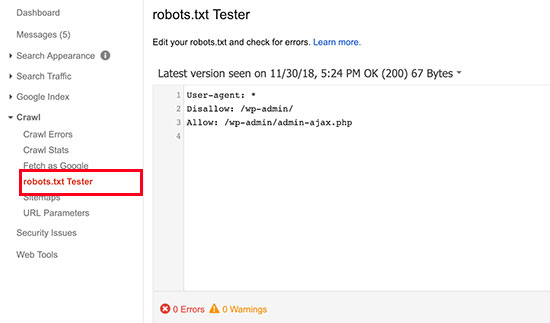

Làm thế nào để kiếm tra file robots.txt

Có khá nhiều cách nhưng tôi khuyên bạn nên dùng cách sau.

Đó là truy cập Google Search Console chuyển sang version cũ.

Và nó sẽ trở lại giao diện quan thuộc ngày xưa của Google Webmaster Tools.

Chuyển sang phần Crawl » robots.txt tester

Công cụ này sẽ tự động kiểm tra và tìm ra các lỗi có trên file robots.txt của bạn sau đó đưa ra cảnh báo.

Kết luận

Mục tiêu cuối cùng khi tối ưu file robots.txt đó là cho phép công cụ tìm kiếm crawl những thứ thực sự cần thiết trên website bạn và disallow một số page không cần thiết như admin, plugins, theme.

Hãy tự tối ưu và lựa chọn những gì cần thiết trên website của bạn.

Tôi hy vọng bài viết này giúp bạn hiểu file robots.txt là gì và cách tạo file robots.txt tối ưu cho SEO.

Đừng quên đọc Hướng dẫn cơ bản về SEO của tôi và công cụ SEO tốt nhất sẽ giúp bạn hiểu hơn về SEO.

Nếu có bất kỳ thắc mắc hoặc câu hỏi hãy comment ở dưới nhé !